« Les machines vont-elles remplacer les humains ? » Nous sommes en 1940, et Franklin D. Roosevelt, dans un débat avec le président du MIT, s’inquiète de l’impact des machines sur la courbe du chômage. Seize ans plus tard, à la conférence de Dartmouth, l’intelligence artificielle (IA) s’invite officiellement parmi les disciplines scientifiques. Cette fois, c’est sûr, les robots vont remplacer les humains. Ce n’est plus qu’une question d’années, de mois peut-être… Soixante ans après, nos collègues de travail sont bien de chair et d’os, et nos ambitions sont finalement revues à la baisse. Dernier exemple en date : la voiture autonome, qu’on prévoyait pour 2020 il y a 4 ans. Un conseil : gardez votre permis de conduire pour une dizaine d’année au moins.

Oui, il est probable qu’un jour, une intelligence artificielle saura tout faire aussi bien qu’un humain, comme Geoffrey Hinton, lauréat du Prix Turing 2019 le prédit. Mais, ce n’est pas une affaire de mois, ni même d’années… Un demi-siècle ? Quelques centaines d’années ? Plus ? Il serait bien hasardeux de se lancer dans des estimations.

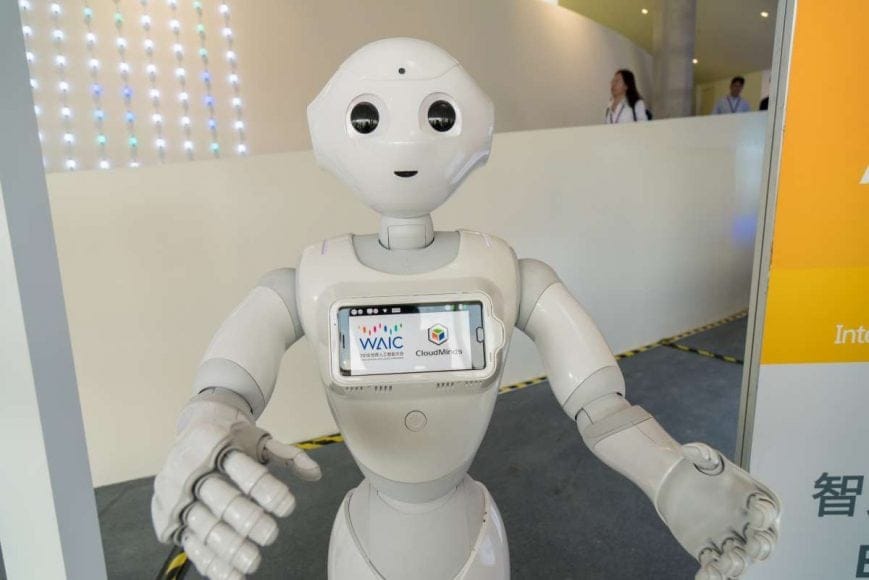

Les chercheurs se heurtent en effet à plusieurs obstacles majeurs qui contraignent l’IA à demeurer à un stade « faible ». Les algorithmes sont pour le moment capables de résoudre des problèmes “spécifiques” pour lesquels on les a entraînés (par exemple les jeux), d’interpréter de façon sommaire les données sensorielles (reconnaissance vocale et visuelle) et même de générer des voix, des textes ou des images, comme l’a récemment présenté Samsung entre autres. Le « deep learning », qui s’appuie sur des réseaux de neurones artificiels, nous a fait faire un bond en avant ces dernières années. Mais ce n’est pas parce qu’une IA est capable de battre le champion du monde du jeu de Go ou n’importe quel être humain aux échecs qu’elle est « forte » pour autant. Allez donc demander à AlphaGo de se souvenir de votre liste de course pour vous en convaincre, vous ne risquez pas de revenir du supermarché bien chargé. On estime même que le quotient intellectuel de l’intelligence artificielle aujourd’hui serait équivalent à celui d’un enfant de 4 ans (résultat qui doit être interprété avec des pincettes, l’IA testée ayant été programmée spécifiquement pour les compétences évaluées par le test). De quoi rassurer le président Roosevelt.

4 domaines majeurs ne sont en effet pas encore maîtrisés par cet « enfant de 4 ans », sur lesquels nous, humains, gardons un sérieux avantage.

· La planification et l’adaptation autonome. Imaginez un robot agent de propreté dans un parc. S’il n’a bientôt plus de batterie, il ne sera pas capable de générer lui-même un plan pour se recharger. Les programmeurs devront avoir intégré un système pour qu’il repère la zone de charge et s’y rende. Et si un jour cette zone est hors service, il ne saura pas s’adapter tout seul, sauf si le cas a été prévu en amont par les concepteurs de l’algorithme – là où un agent humain n’aurait aucun problème à imaginer un plan de secours si la sandwicherie du parc est fermée. Bref, dans un environnement incertain, nos intelligences artificielles n’ont plus grand-chose d’intelligent. Certes, la combinaison des techniques actuelles d’IA de « deep learning » et d’ « apprentissage par renforcement » permet à notre robot d’apprendre de son milieu et des changements qui y sont opérés, mais uniquement dans des environnement clos aux règles fixes et connues, comme sur le plateau d’un jeu de go ou d’échecs par exemple – pas sur un réseau routier, ou l’imprévu peut survenir à tout moment.

· La capacité d’apprendre avec peu d’exemples. Prenons ce même robot, dans ce même parc. Pour identifier le chien qui approche comme une potentielle menace, il lui aura fallu ingurgiter des millions de photos avec et sans chiens en amont. Car aujourd’hui, aussi « intelligents » qu’ils soient, nos algorithmes ont besoin de quantité d’exemples pour être à même de reconnaître ce qu’est un chien, un arbre, une table. L’enfant de quatre ans, lui, n’a pas eu besoin de milliers ou de millions d’exemples de chiens pour en reconnaître un. Un axe de recherche, appelé « transfert learning », permettrait à notre robot d’apprendre à reconnaître l’environnement dans lequel il se trouve, aussi varié qu’il soit, à partir d’un nombre réduit d’exemples.

· L’apprentissage à partir d’explications. Aujourd’hui, les algorithmes d’IA sont entraînés uniquement avec des exemples mais ne peuvent pas bien tirer parti d’une conceptualisation de ce qu’ils ont appris. On peut dire à un enfant qu’une panthère est un gros chat, et qu’un bateau n’a pas de jambe, sinon il marcherait. Il saura donc reconnaître des panthères et ne s’attendra pas à voir une photo avec un bateau en short. Une machine ne peut pas faire cela, elle ne saura pas identifier de panthère si elle n’a pas vu de nombreux exemples avant et ne sera jamais gênée par une photo de catamaran qui gambade.

· L’explicabilité des résultats. Les humains sont la plupart du temps capables, lorsqu’on leur demande, d’expliquer au moins partiellement pourquoi ils ont pris telle ou telle décision. Les IA les plus avancées sont de bien piètres pédagogues au moment de nous expliquer la façon dont elles ont résolu un problème. C’est un souci à l’heure où elles assistent de plus en plus de banquiers, d’assureurs ou de médecins. Les algorithmes modernes de deep learning sont constitués de millions de neurones artificiels qui se sont organisés entre eux, et qui une fois entraînés fonctionnent en mode “boite noire” : même ceux/celles qui les ont conçus ne peuvent interpréter facilement les résultats de leur fonctionnement. C’est à la fois pratique (ils peuvent résoudre très vite des problèmes très complexes) et extrêmement problématique : comment justifier à votre client ce refus de prêt décidé par un algorithme ? Et comment comprendre que cette voiture autonome a décidé une manœuvre extrêmement risquée, au prix de dégâts matériels ou même humains ? Même si c’est la bonne décision, comment faire confiance à une intelligence artificielle lorsque celle-ci fait un diagnostic contraire à celui d’un médecin spécialiste ?

Ces blocages font des intelligences artificielles d’aujourd’hui des IA « faibles », sur lesquelles l’humain a le dessus. D’autant que les chercheurs se heurtent à un problème de formalisation théorique des algorithmes utilisés. Certains théorèmes existent, mais notre expertise s’appuie encore beaucoup sur un savoir empirique et pas toujours sur des théories mathématiques implacables. On tâtonne, on avance, on modifie, pour enfin parvenir à nos fins. Car si les machines ont parfois du mal comprendre les humains, les humains aussi ont du mal à comprendre comment fonctionnent leurs machines.

Philippe Rolet, CTO d’Artefact, en charge du département d’exploration IA

Vous avez aimé cet article ? Likez Forbes sur Facebook

Newsletter quotidienne Forbes

Recevez chaque matin l’essentiel de l’actualité business et entrepreneuriat.

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits