Hyperconnectivité, forte croissance des objets connectés et explosion de la technologie mobile et des médias sociaux sont autant de facteurs qui ont conduit à une grande accessibilité des données : des données volumineuses, multiformes, provenant de multiples canaux et disponibles de plus en plus rapidement.

Paradoxalement, cette explosion de la data, en plus de venir en support à la prise décision en entreprise à de multiples niveaux, ajoute de la complexité à celle-ci. Les managers se retrouvent dans un environnement de plus en plus empreint d’instantanéité et d’incertain nécessitant une intelligence situationnelle sans faille et des systèmes dotés d’une grande flexibilité.

Cet environnement complexe appelle donc à pousser les frontières du digital en intégrant le cognitif. Plus que jamais le cognitif est indispensable aujourd’hui pour créer de la valeur. Le raisonnement sur la data permet de capitaliser sur une ressource rare et cruciale pour les entreprises : la connaissance. Si la data ne sert que des systèmes de support à la prise de décision réagissant à des stimuli et répondant à des schémas préétablis, elle ne pourra pas soutenir l’apprentissage et ne permettra pas à ces systèmes de créer du sens.

Il est sans rappeler que l’entreprise est un lieu intellectuel par excellence : on réfléchit, on interprète, on imagine, on structure donc on raisonne. On ne fait pas que réagir. Les managers doivent ainsi avoir la capacité d’apprendre et de désapprendre vite, les systèmes aussi !

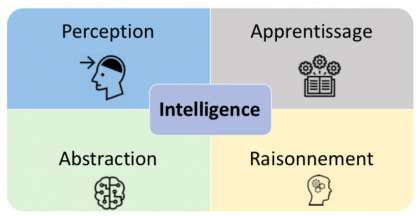

Intelligence ?

Ainsi, si le présent est digital, le futur est résolument cognitif. La connaissance y est capitalisée et sublimée au contact d’autres connaissances pour bâtir de manière incrémentale, progressive et révisable une intelligence imprégnée de sens.

Pour doter les systèmes de capacités cognitives, l’intelligence artificielle représente un relais de taille et y contribue fortement. Cette contribution n’est ni binaire ni uniforme. Pour s’en saisir, il faudra explorer quatre dimensions : la perception, l’apprentissage, l’abstraction et le raisonnement.

Que perçoivent les systèmes ?

Cela inclut le périmètre de l’environnement dans lequel le système est conscient d’exister. Il s’agit ici non seulement du volume de data que le système collecte mais également du degré de précision de cette data et de sa qualité. Un système qui perçoit en continu les stimuli peut permettre une plus grande proactivité et une meilleure adaptabilité. Ce système sera d’autant plus intelligent s’il est capable de questionner son contexte et ainsi de pousser les frontières de sa perception de manière autonome et dynamique.

Sont-ils capables d’apprentissage ?

Cela représente la capacité d’un système à apprendre des situations dans lesquelles il a été utilisé. L’apprentissage est fondamental pour que le système capitalise sur ce qui s’est produit dans le passé pour être de plus en plus performant dans la prédiction et donc l’anticipation de ce qui risque d’arriver dans le futur. On peut distinguer plusieurs types d’apprentissage dont l’apprentissage statistique qui est guidé par de gros volumes de données.

Sont-ils capables d’abstraction ?

Cela renferme les aptitudes du système à déduire de nouveaux concepts et d’agréger des notions auxquelles il n’a pas été programmé de manière explicite. Contrairement aux cas les plus « classiques » où le système applique des règles ou des instructions sur des faits qu’il observe, l’abstraction consiste à observe des faits et à en abstraire de nouvelles règles/approches/modes de raisonnement.

Comment raisonnent-ils ?

Cela représente le degré de sophistication des approches cognitives utilisées ainsi que la complexité des concepts manipulés. Est-ce que le système raisonne sur des données exclusivement structurées ? Semi-structurées ? Manipule-t-il des connaissances et des règles logiques ? Se base-t-il sur des concepts stricts ou flous ? Est-il capable de préciser quelles informations lui manquent pour structurer parfaitement une prédiction ou une prescription ?

Quels défis pour les systèmes de demain ?

La mise en place et l’appropriation de ces systèmes en entreprise aujourd’hui nécessiteraient des actions concrètes à la fois sur les paradigmes IA et sur leur mise en application.

Capacité à répondre à un problème et non à une tendance

Adopter une IA au sein de l’entreprise ne consiste pas uniquement à superposer des algorithmes pour résoudre des problèmes plus ou moins bien formulés. En effet, la résolution d’un problème passe inévitablement par une définition précise et éclairée dudit problème.

On ne peut pas prétendre aujourd’hui pouvoir résoudre tous types de problèmes en entreprise (et ils sont multiples et variés) en s’appuyant sur les mêmes techniques miracles. Un vrai travail de définition du besoin, des incertitudes, d’audit de la donnée à disposition est indispensable pour sélectionner la ou les techniques appropriées à déployer.

(Re)faire confiance à l’IA

On observe un certain défaut de confiance depuis quelques années sur de nombreuses techniques d’IA, notamment sur le respect des données privées, le fonctionnement en boîte noire et les biais de tous genres dont souffrent certains algorithmes.

En effet, pour une adoption sereine de ces techniques, il est indispensable de conscientiser ces défaillances et de garantir plus de transparence à la fois sur la perception (la donnée captée) et sur le raisonnement (le pourquoi et le comment)

L’omniprésence de l’IA dans nos vies professionnelle ou personnelle, publique ou privée, diffusable ou intime ajoute à la peur que les choses nous échappent. Une peur d’autant plus exacerbée par le manque de connaissances sur les techniques de l’IA. Un premier pas serait la formation et la compréhension de ces paradigmes sans pour autant aller aux aspects purement techniques. Une démocratisation des accès à la connaissance de ce champ disciplinaire est une nécessité. Certes, il faut contrôler/surveiller l’IA mais il faut aussi former/sensibiliser l’humain

Expliciter / Justifier

La confiance passe par la compréhension des modes de fonctionnement des algorithmes. L’utilisateur a besoin de se saisir de la logique de raisonnement de ces systèmes afin de mieux les appréhender et donc de les adopter avec une posture sereine et consciente.

Prenons l’exemple des techniques de Machine Learning et de Deep Learning, célèbres pour leur performance en prédiction, en classification dans de nombreuses applications à succès : la reconnaissance de formes, le diagnostic médical, la traduction temps-réel, etc. Ils souffrent particulièrement de ce défaut d’explicabilité. L’utilisateur reçoit des recommandations et/ou des prédictions mais ne comprend pas par quel chemin logique le système est arrivé à cette solution.

Mettre l’humain au cœur de ces systèmes

Outre la formation et la sensibilisation déjà évoquées, l’humain doit être remis au cœur des algorithmes en assurant une co-construction constante IA/Humain. Cela passe par un élargissement de la perception afin de mieux assimiler et capter les connaissances et expertises humaines.

De plus, l’humain est capable de renforcer les qualités d’apprentissage par du feedback explicite qui viendrait apporter de la rigueur logique aux techniques d’apprentissage classiques et appuyer, par conséquent, les capacités cognitives par la dimension humaine. Cela permettrait de développer une intelligence situationnelle dans laquelle le regard humain est un élément essentiel et structurant.

Pouvoir compter sur des systèmes de moins en moins gourmands en data

L’un des axes de progrès indispensables est de pouvoir freiner la course à la data à laquelle se livre bon nombre d’entreprises. Certes, la data est cruciale pour se faire une idée de l’environnement dans lequel on évolue mais comment peut-on compter sur moins de data sans sacrifier la qualité des algorithmes ?

Ce challenge est d’autant plus vital pour les petites entreprises qui ne se fondent que sur une quantité limitée de données et qui exigent malgré tout une bonne qualité de raisonnement et d’apprentissage. Les algorithmes d’apprentissage qui existent aujourd’hui sont statistiquement impressionnants mais très peu fiables sur des volumes de données limités.

L’hybridation est créatrice de valeur

L’IA sera résolument hybride. Hybride en partie grâce à l’intégration de paradigmes qui se sont mutuellement exclus jusque-là. Tout laisse à penser qu’un défi de taille serait de penser des ponts entre des systèmes qui raisonnent sur des règles et de la logique et des systèmes d’apprentissage statistique. Des ponts et des logiques d’intégration doivent également être pensés entre l’intelligence humaine et l’intelligence artificielle.

Ainsi, le défi est de faire cohabiter et interagir des visions différentes du raisonnement artificiel et du raisonnement humain pour co-construire du sens.

Tribune rédigée par Imène Brigui est professeure en Intelligence Artificielle à emlyon business school

<<< À lire également : Intelligence artificielle : 10 prévisions pour 2021 >>>

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits