Le « Shadow Banning », également connu sous le nom de « stealth banning », · « ghost banning » ou encore « comment ghosting », ce qui peut être traduit en français par « bannissement furtif » ou « bannissement silencieux » est une pratique extrêmement controversée sur les réseaux sociaux.

«Le Shadow Banning » pour les « observateurs-usagers-victimes » de la pratique « supposée » peut se présenter de différentes manières, telles qu’un contenu ayant moins de vues, moins de cœurs (like) ou de partages, moins de commentaires ou simplement un infléchissement de la visibilité des publications dans une partie du public au regard du nombre de suiveurs de l’utilisateur cible et au regard de l’usuel. Cette invisibilisation, si elle est prolongée, finit invariablement par une baisse drastique de suiveurs des personnes « ciblées ». La controverse advient dès lors que, par-delà des constats d’usagers qui remarquent qu’ils sont limités en termes de visibilité sur certaines publications et le font savoir sans pour autant en comprendre les raisons de manière explicite. Il est à noter que cette pratique a toujours été déniée par les réseaux incriminés. Ainsi, et pour « plagier » Cioran qui disait que « Dieu est, même s’il n’existe pas », « Le Shadow Banning est, même si les plateformes disent qu’il n’existe pas ». N’oublions jamais par ailleurs qu’au côté de la liberté d’expression que nous abordons, le Shadow Banning revêt, et c’est un tout autre sujet une dimension économique. Être « Shadow Ban » sur Instagram par exemple peut être très dommageable pour un compte d’entreprise ayant intégré ce RS dans sa stratégie digitale.

Être au courant de cette pratique « vraisemblable » est essentiel pour comprendre comment cela peut affecter la liberté d’expression en ligne et façonner une opinion publique.

Le « Shadow banning », pourquoi ?

Les raisons d’un « Shadow Banning » ciblé peuvent être diverses. La raison peut être parfaitement « légitime », la modération de contenus inappropriés ou qui sont jugés contraires aux règles de la plateforme… selon des critères qui sont néanmoins parfaitement obscurs et bien au-delà des règles d’usages formalisées, cela peut être des contenus qui peuvent, par exemple, être dénoncés massivement par des usagers : imaginons le contenu posté par un opposant, et signalé par une centaine de troller d’un parti auprès de la plateforme… qu’adviendra-t-il selon vous par simple principe de précution ? – Si « la modération » constitue une explication plausible, si cette modération peut être à l’évidence « influencée » le dévoiement intentionnel de cette modération peut constituer un autre motif visant à valider la promotion de la parole dominante, en effet un contenu sort du cadre légal et se doit d’être supprimé, ou il n’en sort pas, s’il n’en sort pas quelle est la justification pour le maintenir en ligne et le rendre invisible. Il demeure donc essentiel de se rappeler que le « Shadow Banning » pourrait (peut) être utilisé pour discréditer, affaiblir, en les rendant invisibles des voix impopulaires : opposants, dissidents, scientifiques, Etc. En comprenant cette logique, en dépassant le simplisme de traiter ceux et celles qui constatent, ceux et celles qui informent, de « complotistes » les internautes seront peut-être plus à même de reconnaître cette cybermenace active qui touche la liberté d’expression.

Une pratique ancienne, « popularisée » par Donald Trump.

Si la pratique soupçonnée est ancienne – cette pratique « supposée » est apparue dans les années 80 pour la première fois, « afin de modérer certains forums » – elle a été véritablement « popularisée » lors des élections américaines, de 2018 et relancé la controverse : Le vingt-six juillet 2018, soit environ quatre mois avant les élections américaines qui devaient se tenir le six novembre de la même année et que la ” bataille” sur les réseaux sociaux était engagée Donald Trump tweetait : ” Twitter « SHADOW BANNING » d’éminents républicains. Ce n’est pas bon. Nous allons nous pencher immédiatement sur cette pratique discriminatoire et illégale ! Beaucoup de plaintes. !

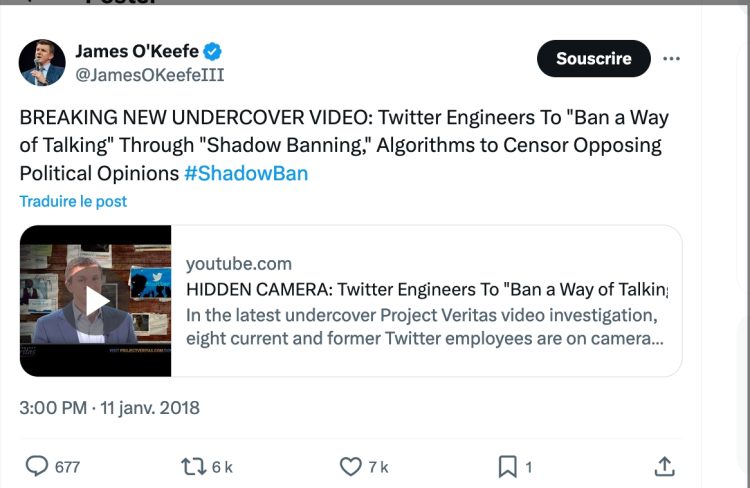

Le jour suivant c’est un article de Vice-News qui rapportait que certains hauts responsables républicains n’étaient pas visibles dans les résultats de recherche automatique. Ce que le journal avait alors qualifié d’ « interdiction fantôme » sans toutefois être en mesure des preuves d’une procédure délibérée. Les médias conservateurs tels qu’Infowars et Breitbart ont rapidement repris l’histoire, qu’ils ont, pour leur part, considérée comme une validation de leurs soupçons de longue date. Le jeudi matin, Project Veritas – l’entreprise médiatique de James O’Keefe – suivant le mouvement publiait une vidéo « prétendant » montrer un ingénieur de Twitter admettant cette pratique.

Lien vers la vidéo : « HIDDEN CAMERA »

Le Shadow Banning, comment ? Trois indices d’un « possible » Shadow Banning et un exemple concret.

Bien que les conséquences du Shadow Banning ne soient pas directement visibles, certaines preuves, ou plutôt indices peuvent suggérer aux utilisateurs que leurs comptes sont probablement frappés par le « phénomène ».

Premier indice :

le manque marqué de likes et de réactions, l’absence de partages des followers sous les publications peut indiquer un Shadow Banning. Si peu de personnes réagissent aux publications au regard du nombre de suiveurs et de résultats usuels, il est fort probable que celle-ci ne soit pas visible par tous les suiveurs (followers), attention : Facebook à la différence d’autres réseaux ne se cachent pas, après avoir fait fortune sur le dos de la notoriété de certains utilisateurs, de conditionner désormais la visibilité de leurs publications par leurs abonnés – qui n’ont sauf erreur ou omission pas été contraints à les suivre – à paiement ! Même si cela ne les exempts pas de la pratique, cela n’est pas du Shadow Banning à proprement parler, c’est juste du « business », un business assez « ingrat » et peu reconnaissant ce ceux et celles qui, du fait de leur notoriété, ont originellement contribué alors à leur succès, et ce dans la mesure ou les suiveurs n’ont pas été contraint à suivre des comptes ou des pages.

Second indice :

La perte soudaine d’un nombre de followers ou amis sur les réseaux sociaux est un signal évident d’un Shadow Banning. Si le nombre de personnes réagissant ou partageant une publication commence à diminuer régulièrement sans raison évidente, cela peut indiquer que la censure est en marche ! .

Troisième indice :

L’absence desdites publications dans les résultats de recherche ou la disparition des fils d’actualités des abonnés. Si une personne publie quotidiennement et que ses publications n’atteignent jamais l’audience souhaitée, alors le Shadow Banning est « potentiellement » activé. Tous ces signaux doivent être des alertes pour les utilisateurs de médias sociaux. Cela les aidera non seulement à conserver leur liberté d’expression en ligne, mais également à réagir de manière appropriée.

Un exemple concret :

L’écrivain Tonvoisin, connu du grand public pour ses nombreux essais à succès sur les « Cons » dont « Travailler avec des cons » (J’ai lu 2009) récemment arrivé sur Tik Tok en 2024, nonobstant un nombre de suiveur extrêmement faible au regard du nombre d’abonnés sur d’autres Réseaux a été Shadow Banned suite à un post « taquinant le pouvoir » qui faisait suite au déclaration du président français du 27 février 2024 qui disait ne pas exclure « l’envoi de troupe au sol », ce post ( ici) en date du 28 février, a été vue 21 500 fois, par la suite en observant son compte ses vidéos suivantes ont été vue 250 voies puis désormais sa visibilité oscille entre zéro et six vues (cf Tonvoisin, compte officiel )

Qui sont les responsables… Quelles conséquences ?

D’autres questions se posent, des questions qui peuvent permettre de mieux comprendre la logique de cette pratique : qui en sont les potentiels maitres d’œuvre ? Quels sont les dégâts psychiques qui peuvent être engendrés sur une « victime » de méthodes dignes de la Stasi ?

Les responsables « potentiels ».

Les Plateformes en Ligne :

Les entreprises qui possèdent et exploitent les plateformes sociales et les forums en ligne possèdent naturellement toutes les autorisations et les capacités techniques pour mettre en oeuvre le « Shadow Banning ».

Les Administrateurs des Plateformes :

Dans bien des cas, les administrateurs des plateformes ont une autorité sur les politiques de modération du contenu, et peuvent choisir d’implémenter le Shadow Banning comme mesure et outil de modération.

Les Modérateurs de contenu :

Si les administrateurs sont en charge de la gestion du réseau (création, modification, suppression des comptes utilisateurs). « Les modérateurs sont les personnes habilitées à gérer les paramètres d’un espace de travail, d’un modèle de checklist ou encore d’une équipe ». Les modérateurs de contenu humains peuvent également modifier, rendre privé, ou restreindre l’accès à des comptes sur la base de violations des règles de contenu.

Les Algorithmes de modération :

Les algorithmes de modération automatisés peuvent être programmés pour identifier des comptes d’utilisateurs et les restrictions, selon certains critères préétablis, sans qu’il n’y ait d’interaction humaine directe.

Les Gouvernements ou des “Organisations” :

Dans certains cas, il est possible qu’un gouvernement ou une organisation exerce de la pression sur une plateforme en ligne pour limiter ou censurer des contenus ou des utilisateurs spécifiques, menant indirectement à à l’implémentation du Shadow Banning.

Quelles conséquences pour les « Shadow Banned ?

Lorsqu’une personne est « Shadow Banned », au regard des conséquences, cette personne peut alors être incitée à s’autocensurer : les utilisateurs qui se pensent ciblés peuvent « sous contraintes » décider d’éviter d’émettre des opinions ouvertement controversées de peur d’être à nouveau censurées ou exclues. Ces tendances à supprimer le dialogue ouvert en démocratie étouffent le débat et restreignent la libre circulation des idées. En tant que tel, il est nécessaire de sensibiliser les usagers aux répercussions du Shadow Banning sur la liberté d’expression pour protéger cette valeur en ligne. Il est essentiel de comprendre comment leur contenu est filtré et pour quelle raison. À cet égard, il est important pour les réseaux sociaux de devenir plus transparents. En outre, il est impératif que les plates-formes en ligne tiennent compte des conséquences qui peuvent résulter de telles politiques de « modération », sur ceux et celles qui en sont victimes. Inutile d’être psychiatre pour postuler que ceux et celles qui en sont victimes peuvent être impactés, les conséquences peuvent naturellement varier selon l’usager, son identité, sa situation « générale » sa sensibilité, ses expériences passées sur la plateforme et sa perception de l’événement. Cependant, dans de nombreux cas, le Shadow Banning peut avoir un effet délétère sur le bien-être psychologique des utilisateurs concernés, que cela soit une simple perte de confiance dans la plateforme, cela peut également générer de la frustration , provoquer un sentiment d’isolement social, une baisse de l’estime de soi, une méfiance, pour ne pas dire de la paranoïa, à savoir,, commencer par exemple à se méfier des autres membres de la communauté, dans tous les cas et les experts pourront mieux l’évoquer bien plu précisément que je ne le fais, l’impact est rarement « neutre ».

Les solutions et alternatives au Shadow Banning.

Quand bien même la pratique est niée par les acteurs qui en sont soupçonnés et parfois accusés, la pratique a du mal à résister aux constats et suscite de plus en plus de préoccupations en raison de ses répercussions sur la liberté d’expression en ligne. Plusieurs solutions alternatives peuvent être envisagées pour lutter contre cette forme de censure par omission. Plusieurs mesures pourraient être prises pour mettre fin à cette controverse :

• Une transparence accrue.

Une transparence accrue est essentielle pour les plateformes de réseaux sociaux. Les utilisateurs devraient recevoir des notifications lorsqu’ils sont soumis à des restrictions ou lorsqu’ils subissent, ou risquent de subir une « démonétisation » de leurs messages en raison de l’algorithme, il faudrait à l’instar de « Chat Gpt » – qui informe l’usager lorsque le « prompt » de ce dernier lui apparait poser problème » – une alerte de l’usager lorsque le contenu est « suspecté » que ce dernier puisse se justifier. De cette façon, pourraient regagner la confiance de leurs utilisateurs et réduire les inquiétudes de ceux-ci concernant la censure.

• L’acceptation de l’implication des usagers.

Les utilisateurs doivent être davantage impliqués dans le processus de gestion des contenus. Les plateformes devraient mettre en place un mécanisme via lequel les utilisateurs signaleront des cas de censure injuste. Dans ce cas, les jurys indépendants devraient prendre lesdites décisions équitables.

• Combattre les effets « chambre de l’écho ».

Il est important d’assurer une diversité des points de vue en ligne. Les plateformes de réseaux sociaux peuvent encourager la création d’espaces et de communautés diversifiés dans lesquels plusieurs voix peuvent être entendues. En plus, les efforts doivent être déployés pour lutter contre les effets « chambre de l’écho » (dans les médias de la communication, une chambre d’écho, ou chambre d’écho médiatique est une description métaphorique d’une situation dans laquelle l’information, les idées, ou les croyances sont amplifiées ou renforcées par la communication et la répétition dans un système défini.)

En résumé, j’estime, comme d’autres experts que les autorités étatiques pourraient réglementer certains des aspects du comportement du réseau social. Dans ce cas, la législation et les règlements spéciaux pourraient être adoptés pour protéger la liberté d’expression et concourir la limitation d’abus. Il est urgent de proposer des solutions alternatives efficaces au Shadow Banning. L’une des conditions fondamentales pour assurer une véritable liberté d’expression en ligne sur les réseaux sociaux est de protéger la diversité des opinions, ce n’est pas à ce jour le cas !

Pour conclure :

Le « Shadow Banning » ainsi que d’autres formes subtiles de censure par intimidation à quelque niveau que cela soit : Déclassement dans les résultats de recherche, suspension de compte temporaire ou permanente, etc. peuvent conduire – si ces pratiques ne sont pas dénoncées, combattues et empêchées – à une uniformisation de la pensée et à une triste pauvreté de l’arène publique en ligne. La lutte contre cela devrait se faire sous le couvert de politiques claires et transparentes en matière de gestion des contenus de la part des plateformes. Elles se devraient déjà, et ce, avant de procéder à une invisibilisation, voire à la suppression d’un contenu, garantir d’avoir vérifié ce contenu pour s’assurer que ces derniers n’ont pas été ciblés par des trolleurs* (*généralement politique). Les utilisateurs devraient, eux, être conscients de ce que cela signifie pour leur publication, à savoir, quels critères peuvent amener à une suppression ou une réduction de leur visibilité. Les plateformes, dans cette dynamique de transparence devraient également donner priorité à de nombreux contenus contradictoires au lieu d’un seul, ce qui garantira une pluralité d’opinions. Dans ce contexte, le besoin de transparence concernant la fonction de l’algorithme de recommandation, l’un des principaux influents de la visibilité des publications, est encore plus évident.

“Les pires censeurs sont ceux qui osent réprimer les idées et font taire les contestations.”

Michael Moore

À lire également : Comment les nouveaux réseaux sociaux servent-ils la liberté d’expression ?

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits